Index و Crawl چیستند؟

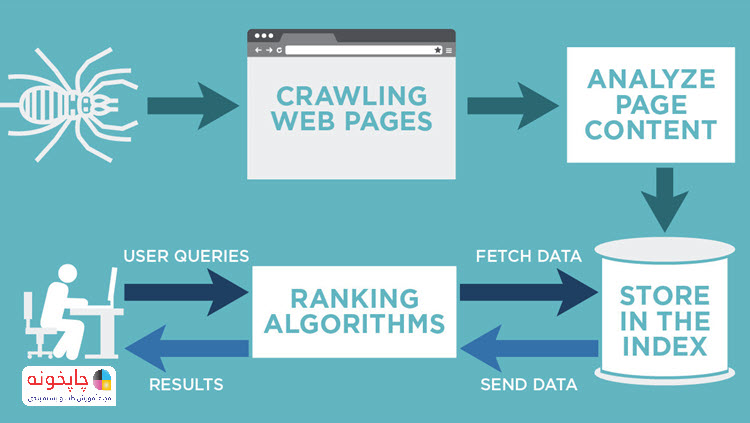

همه ما تا حدودی از نحوه عملکرد موتورهای جستجو آگاهیم. اما در اینجا ما میخواهیم مقداری عمیقتر به این موضوع نگاه کنیم. بیایید با روند عملکردی خزندههای گوگل شروع کنیم.

اصلا خزندههای موتورها جستجو چی هستند؟

خزیدن فرایندی است که توسط خزندههای وب موتور جستجوگر (رباتها یا اسپایدرها) برای بازدید و دانلود یک صفحه و استخراج لینکهای آن به منظور کشف صفحات اضافه شده، استفاده میشود.

صفحاتی که به موتورهای جستجو شناسانده شدهاند، به طور مرتب توسط خزندهها بازدید میشوند تا تخمین بزنند که آیا تغییری از زمان آخرین خزیدن ایجاد شده یا خیر.

اگر یک موتور جستجو پس از خزیدن یک صفحه، تغییرات را در آن صفحه پیدا کند، در پاسخ به این تغییرات شناسایی شده، ایندکس آن را به روز میکند.

خزندهها چگونه کار میکنند؟

موتورهای جستجو از خزندههای وب مخصوص به خود برای کشف و دسترسی به صفحات وب استفاده میکنند. هر خزنده موتور جستجوگر، از طریق دانلود فایل robots.txt آن سایت، که فایلی حاوی قوانین مربوط به صفحاتی است که موتورهای جستجو باید یا نباید در وب سایت جستجو کنند، یک وب سایت را میخزند.

فایل robots.txt همچنین ممکن است اطلاعاتی در مورد نقشههای سایت (Sitemaps) داشته باشد. نقشه سایت شامل لیستهایی از URLهایی است که صاحبان سایت میخواهد که خزنده موتور جستجوگر آنها را بخزند.

خزنده موتور جستجوگر از تعدادی الگوریتم و قواعد استفاده میکند تا تعیین کند که چه میزان یک صفحه مجددا خزیده (re-crawled) میشود و چند صفحه در یک سایت باید ایندکس شود. به عنوان مثال، یک صفحه که به صورت منظم تغییر میکند، ممکن است بیشتر از صفحهای که به ندرت اصلاح می شود، کرول یا خزیده شود.

چگونه میتوان موتورهای جستجو را شناسایی کرد؟

شناسایی رباتهای خزنده موتورهای جستجو از طریق user agent strings که آنها را در هنگام درخواست صفحات وب به سرور وب منتقل میکند، امکان پذیر است. در اینجا چند نمونه از user agent strings استفاده شده توسط موتورهای جستجو وجود دارد:

- Googlebot User Agent

Mozilla/5.0 (compatible; Googlebot/2.1; http://www.google.com/bot.html)

- Bingbot User Agent

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)

- Baidu User Agent

Mozilla/5.0 (compatible; Baiduspider/2.0;+http://www.baidu.com/search/spider.html)

- Yandex User Agent

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots)

هر کس میتواند یک user agent مشابه با موتورهای جستجوگر استفاده کند. با این حال، آدرس IP که درخواست را ایجاد کرد نیز میتواند مورد استفاده قرار گیرد تا تأیید کند که از موتور جستجو آمده است – یک فرایند به نام DNS lookup معکوس است.

کرول کردن تصاویر یا سایر فایلهای غیرمتنی

موتورهای جستجو به طور معمول تلاش میکنند تا هر URL را که با آن روبرو هستند، کرول و ایندکس شوند. با این حال، اگر URL یک نوع فایل غیر متنی است مانند یک فایل عکس، ویدئو یا فایل صوتی، موتورهای جستجو به طور معمول نمیتوانند محتوای فایل را به غیر از نام فایل و متادیتای مرتبط با آن را بخوانند.

اگر چه یک موتور جستجو تنها قادر به استخراج مقدار محدودی از اطلاعات در مورد انواع فایلهای غیر متنی است، اما میتواند آنها را ایندکس کند و موجب رتبه بندی در نتایج جستجو شود. گوگل میتواند محتوای بسیاری از انواع صفحات و فایلها را ایندکس کند. رایجترین انواع فایلهایی که ایندکس میشود عبارتند از:

- (Adobe Flash (.swf

- (Adobe Portable Document Format (.pdf

- (Adobe PostScript (.ps

- (Autodesk Design Web Format (.dwf

- (Google Earth (.kml, .kmz

- (GPS eXchange Format (.gpx

- (Hancom Hanword (.hwp

- (HTML (.htm, .html, other file extensions

- (Microsoft Excel (.xls, .xlsx

- (Microsoft PowerPoint (.ppt, .pptx

- (Microsoft Word (.doc, .docx

- (OpenOffice presentation (.odp

- (OpenOffice spreadsheet (.ods

- (OpenOffice text (.odt

- (Rich Text Format (.rtf

- (Scalable Vector Graphics (.svg

- (TeX/LaTeX (.tex

- Text (.txt, .text, other file extensions), including source code in common programming languages:

- (Basic source code (.bas

- (C/C++ source code (.c, .cc, .cpp, .cxx, .h, .hpp

- (C# source code (.cs

- (Java source code (.java

- (Perl source code (.pl

- (Python source code (.py

- (Wireless Markup Language (.wml, .wap

- (XML (.xml

خزیدن و استخراج لینک از صفحات

خزندهها صفحات جدید را با خزیدن مجدد در صفحاتی که آنها را میشناخته، سپس استخراج لینکها برای پیدا کردن صفحات جدید، کشف میکند. این URL های جدید در صف خزیدن قرار میگیرند تا بتوان آنها را بعدا دانلود کرد.

از طریق فرایند دنبال کردن لینکها، موتورهای جستجو قادرند که هر صفحه منتشر شده در اینترنت را که به حداقل یک صفحه در اینترنت مرتبط یا لینک شده است، کشف کنند.

SITEMAPS

راه دیگری که موتورهای جستجو میتوانند صفحات جدید را کشف کنند این است که خزندهها نقشههای سایت را کرول کنند. نقشههای سایت شامل مجموعهای از آدرسها است که توسط یک وب سایت ایجاد میشود تا به موتورهای جستجو، لیستی از صفحاتی رت که میبایست کرول شوند، ارائه دهد.

این نقشهها از طرفی میتواند به موتورهای جستجو کمک کند تا محتوای پنهانی عمیق در وب سایت را پیدا کند و از طرف دیگر به مدیران وب در توانایی بهتر کنترل و درک بخشهایی از سایت که ایندکس شده کمک کند و همچنین تکرار ایندکسها را درک کنند.

PAGE SUBMISSIONS

یک روش دستی برای کشف صفحه است. این روش زمانی مورد استفاده قرار میگیرد که محتوای جدیدی منتشر شده یا یک تغییراتی ایجاد شود و شما میخواهید زمان را برای اینکه موتوهای جستجو آن تغییرات را ببینند کوتاه کنند یا به حداقل برسانید.

گوگل میگوید که برای حجمهای خیلی بالا از URL شما باید از نقشههای XML استفاده کنید، اما گاهی روش ارائه دستی هنگام ارسال تعدادی از صفحات مناسب است. همچنین مهم است که توجه داشته باشید که گوگل سرچ کنسول این تعداد را محدود کرده است.

علاوه بر این، گوگل میگوید زمان پاسخگویی برای ایندکس کردن نقشههای سایت و ایندکس دستی یکسان است.

Crawl و Index چیست؟

یکی از نکاتی که برای سئو بهتر سایت باید به آن توجه کرد، میزان دسترسی موتورهای جستجو به صفحات هدف است. این دسترسی با خزیدن یا Crawl رباتهای موتورها به سایت صورت میگیرد. پس از آن، صفحهای که رباتها به آن خزیدهاند باید در فهرست قرار گرفته یا Index شود. به این دلیل از واژه هدف استفاده شد که برخی از قسمتهای سایت ممکن است توسط ادمین از طریق فایل ربات از دسترس خارج شوند.

در ابتدای امر باید بگوییم که ما هنوز نمیدانیم که گوگل چطور سایت ما را Crawl میکند؛ بنابراین بسیاری از سئوکارها هنوز تفاوت بین Crawl و Index را نمیدانند. بزرگترین مشکل این است که زمانی که مشکلات ایندکس شدن را بررسی میکنیم تنها ابزارهای ما Google Search Console است.

به این خاطر که سایت از کدهای HTML و CSS تشکیل شده است، حدس زدن درمورد چرا محتوا توسط گوگل ایندکس نمیشود، سختتر خواهد بود.

حتی اگر قسمتهایی از سایت خود را پیدا کردهاید که میدانید مشکل ایندکس نشدن از آنهاست، بسیار مشکل است که تا ته آن بروید و قطعه کد اشکال دار را پیدا کنید که باعث ایندکس نشدن است.

هر موتور جستجو بودجه خزیدن خاصی را به هر دامنه اختصاص میدهد که بر اساس میزان رتبه صفحه تعیین میشود؛ بنابراین آنها باید اولویتبندی کرده و تا حد امکان به خزیدن در محتواهای باارزش بپردازند.

با استفاده از دستوراتی مثل Nofollow یا فایل ربات در مورد برخی از صفحات کماهمیت، میتوانید بودجه خزیدن یا Crawl سایتتان را بهینه کرده و به عبارتی در مصرف آن صرفهجویی کنید! استفاده از متا تگها برای کنترل این بودجه هم میتواند کمککننده باشد.

پس از اینکه عملیات خزیدن موتورهای جستجو به صفحات وبسایتتان را با موفقیت پشت سر گذاشتید، زمان آن است تا بر نحوه فهرست بندی یا Index کردن آنها توسط موتورها نظارت داشته باشید. لزوما هر صفحهای که خزیدن به آن صورت میگیرد، Index نمیشود و باید گوگل آن را باارزش تشخیص دهد.

پس از ایندکس شدن صفحه، گوگل تصمیم میگیرد که چطور باید در نتایج جستجو دیده شود. این موتور بر اساس عوامل مختلف، تصمیم میگیرد که در هر جستجو، چه کلمات کلیدی و رتبهای به صفحه شما تعلق میگیرد.

جالب است بدانید اگر لینکی برای ایندکس کردن توسط ربات گوگل خزیده میشود تا پنج سایت دیگر که این لینک از آنها نشات گرفته هم خزیده میشوند که اعتبار آن لینکها هم در رتبهبندی صفحه شما تاثیر دارد. به همین دلیل لینک گرفتن از سایتهای باکیفیت و معتبر با استفاده از کلمه کلیدی مورد نظرتان میتواند در ایندکس بهتر صفحات به شما کمک کند.

چگونگی Crawl & Index توسط موتورهای جستجو

بهینه سازی وب سایت بدون درک نحوه کارکرد موتورهای جستجو، مشابه انتشار یک کتاب بدون یادگیری نحوه نوشتن است. بنابراین ما باید درک کنیم که چگونه موتورهای جستجو کار میکنند تا کاملا درک کنیم که چگونه برای آنها بهینه سازی انجام شود.

در حالی که ما روی جستجوی ارگانیک تمرکز میکنیم، ابتدا باید به طور خلاصه در مورد یک حقیقت انتقادی درباره موتورهای جستجو صحبت کنیم.

اساسا، گوگل و بینگ (و سایر موتورهای جستجو) موتورهای تبلیغاتی هستند که کابران را به سمت خود میکشند تا به ارگانیک تبدیل کنند. بنابراین ارگانیک پایان ماجراست.

موتورهای جستجو امروز چگونه کار می کنند؟

- Crawling and indexing

- Algorithms

- Machine learning

- User intent

Indexing

ایندکس جایی است که همه چیز شروع میشود. اگر بخواهیم به صورت آماتور به این موضوع بپردازیم، باید بگوییم که ایندکس کردن اساسا به افزودن یک محتوای وب سایت به گوگل اشاره دارد. زمانی که شما یک پیج تازه میسازید راههای مختلفی برای ایندکس کردن آن برای گوگل وجود دارد.

یک راه آسان این است که در واقع هیچ کاری نکنید. گوگل خزندهها را در پی لینکها میفرستد، در نهایت آن را کشف کرده و آن را به فهرست خود اضافه میکند.

اما آیا راهی وجود دارد که آن را سریعتر به گوگل معرفی کنیم؟

این امر زمانی مهم است که محتوای جدیدی داشته باشید یا تغییرات مهمی در صفحهای ایجاد کردهاید که گوگل نیاز به دانستن آن را داشته باشد.

یکی از دلایلی که از روشهای سریعتر استفاده میکنیم این است که یک صفحه مهم را بهینه سازی کرده یا دیسکریپشن برای یا توضیحات را برای بهبود تجربه کاربر تنظیم کردهایم و میخواهیم به طور خاص زمانی که کاربر آن را سرچ کرد، در SERPs نمایش داده شود. در این موارد چند روش وجود دارد که میتوانید استفاده کنید:

XML Sitemaps

همیشه XML Sitemaps وجود دارد.

اساسا Sitemaps یک نقشه سایت است که از طریق Search Consoleبه گوگل ارائه میشود.

یک Sitemap ، لیستی از تمام صفحات در سایت شما و همچنین جزئیات بیشتر در مورد آن مانند زمانی که آن را آخرین بار تغییر دادهاید، است.

URL Inspection

در Search Console، می توانید «URL Inspection » را پیدا کنید. URL مورد نظر خود را وارد کنید و سپس اینتر را بزنید. پس از آن روی گزینه “Request Indexing” کلیک کنید. به طور کلی در عرض چند ثانیه تا چند دقیقه شما میتوانید محتوای جدید یا URL را در گوگل جستجو کنید و تغییر یا محتوای جدید را مشاهده کنید.

Crawl Budget

نمیتوانیم از ایندکس بدون Crawl Budget صحبت کنیم. بودجه خزیدن یا Crawl Budget یک اصطلاح است برای توصیف مقدار منابعی که گوگل برای یک وب سایت در رابطه با کراول کردن، صرف میکند. بودجه اختصاص داده شده بر اساس ترکیبی از عوامل است که دو مورد اصلی عبارتند از:

- سرور شما چقدر سریع است. به عنوان مثال گوگل چه میزان کراول میکند بدون خسارت به تجربه کاربری.

- سایت شما چقدر مهم است

اگر سایت شما یک سایت خبری مهم باشد که محتوای آن به صورت دائمی به روز رسانی میشود که کاربران موتورهای جستجو تمایل زیادی داشته باشند از سایت شما آگاهی داشته باشند، مرتبا Crawl میشود.

این مطلب عالی بود👏👏👏

دقیقا پاسخی بود که خیلی وقته ذهنمو مشغول کرده بود که فرق crawl با index و جزئیات دیگش چیه!

خیلییییی ممنون